Teknik Pruning Algoritma C4.5 - Pemangkasan Pohon Keputusan

Assalamualaikum Wr. Wb, Salam Rahayu dan Salam Sejahtera

Algoritma C4.5 adalah algoritma pembelajaran mesin yang digunakan untuk membangun model pohon keputusan dari data pelatihan. Model ini dapat digunakan untuk klasifikasi, yang mengkategorikan data ke dalam kelas yang berbeda berdasarkan atribut yang diberikan.

Algoritma C4.5 juga merupakan pengembangan dari algoritma ID3 yang masuk dalam keluarga decison tree. Apa yang dikembangkan dari algoritma ini ada banyak kelebihan seperti bisa mengatasi missing value dan yang lebih kerennya adalah dengan memangkas hasil pohon keputusan yang terbentuk.

Teknik pemangkasan pohon pada algoritma C4.5 sangat penting untuk mencegah overfitting, yaitu kondisi di mana pohon keputusan terlalu rumit dan secara berlebihan menyesuaikan data pelatihan, sehingga kinerja pada data yang belum pernah dilihat sebelumnya menjadi buruk.

Berikut adalah beberapa teknik pemangkasan pohon pada algoritma C4.5 :

1. Minimum Gain Threshold (Ambang Keuntungan Minimum)

Algoritma C4.5 menggunakan metrik "gain ratio" untuk menilai atribut yang paling baik dalam membagi node. Pemangkasan dilakukan dengan membandingkan nilai gain ratio atribut dengan ambang batas tertentu. Jika gain ratio tidak melebihi ambang batas ini, maka pemisahan node tidak dilanjutkan.

2. Maksimum Kedalaman Pohon (Maximum Tree Depth)

Pohon keputusan dapat dipangkas dengan membatasi kedalaman maksimum. Ini membantu mencegah pohon terlalu dalam yang mungkin menjadi terlalu rumit dan overfit pada data pelatihan.

Misalnya : Pada beberapa percobaan yang telah kamu lakukan menggunakan tools atau software dalam hal ini katakanlah rapidminer studio. Disini kamu bisa menentukan batas cabang pohon sesuai keinginan "asalkan" nilai akurasi yang dihasilkan tidak lebih rendah dari sebelum dilakukan pembatasan. Hal ini juga berlaku pada ;

Minimum Jumlah Sampel pada Node Daun :Pemangkasan dapat dilakukan dengan memeriksa jumlah sampel minimum yang harus ada di setiap node daun. Jika jumlah sampel di bawah ambang batas tertentu, node daun tidak akan dibagi lagi.

4. Pruning Pasca-Pelatihan (Post-Pruning)

Teknik ini melibatkan membangun pohon keputusan yang sempurna dari data pelatihan, dan kemudian melakukan pemangkasan node-node yang tidak signifikan dengan menghapus subpohon yang memberikan sedikit kontribusi terhadap kinerja klasifikasi secara keseluruhan pada data validasi atau data pengujian terpisah. Atau memangkas pohon karena pada cabang-cabang dibawah nya memiliki hasil atau label yang sama

Contoh :

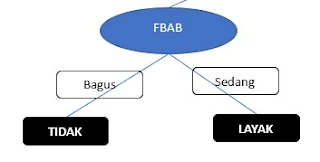

Coba perhatikan pohon keputusan diatas.

Bisa dilihat hasil dari node-node kebawah setelah melakukan berbagai perhitungan gain atau gain ratio. Nah, dengan memperhatikan secara seksama bahwa node dari kanan dan kiri membentuk satu kelas atau label yang sama dimana dari sisi kiri membentuk label "TIDAK" dan sebelah kanan label "LAYAK".

Disini kamu, bisa memangkas nya menjadi seperti ini :

Apakah ini sah ?

sah-sah saja, karena sejauh ini belum ada referensi yang menolak metode tersebut. Namun perlu diperhatikan juga, bahwa akurasi yang dihasilkan juga harus baik minimal tidak lebih rendah dari akurasi pohon yang belum dipangkas.

5. Cross-Validation (Validasi Silang)

Cross-validation dapat digunakan untuk menguji kinerja model pohon keputusan pada data validasi yang tidak digunakan selama pelatihan. Jika pohon memiliki kinerja yang buruk pada data validasi, maka pemangkasan tambahan dapat dilakukan.

Baca juga : Tutorial cross validation menggunakan rapidminer studio

Bisakah teknik pemangkasan diambil dari hasil selisih jumlah label nya ?

Ya, kamu dapat menggunakan selisih jumlah label sebagai kriteria untuk melakukan pemangkasan pada pohon keputusan.

Teknik ini dapat membantu Anda mengidentifikasi node-node yang memiliki perbedaan signifikan dalam jumlah sampel pada label yang berbeda, dan kemudian mempertimbangkan untuk memangkas atau menggabungkan node tersebut.

Contoh

Dalam contoh kasus diatas, kita bisa menghitung selisih guna untuk memangkas pohon keputusan. Caranya adalah- Hitung jumlah label A : atau dalam contoh label "LAYAK" pada sub atribut 1

- = 15 / 25 = 0.6 = 60%

- Hitung jumlah label B : atau dalam contoh label "TIDAK" pada sub atribut 1

- = 10 / 25 = 0.4 = 40%

- Hitung jumlah label A : atau dalam contoh label "LAYAK" pada sub atribut 2

- = 10 / 13 = 0.77 = 77%

- Hitung jumlah label B : atau dalam contoh label "TIDAK" pada sub atribut 2

- 3 / 13 = 0.12 = 12 %

- Klause 1 atau Sub Atribut 1 selisihnya adalah 60% - 40% = 20%

- Klause 2 atau Sebu Atribut 2 selisihnya adalah 77% - 12% = 65%

Nah, untuk menentukan seberapa persen selisih agar bisa melakukan teknik pemangkasan, kita bisa menentukan diatas 40-50 persen sebagai ambang batas maksimumnya.

Jadi dengan kondisi seperti itu maka pohon keputusan bisa digambarkan seperti dibawah ini :

Dimana "?" status label belum diketahui karena ambang batas selisih masih dibawah 40 atau 50 persen yang bernilai hanya 20% saja. Jadi harus melakukan perhitungan lagi.

Kesimpulan

Penting untuk dicatat bahwa pemangkasan pohon keputusan pada algoritma C4.5 harus dilakukan dengan hati-hati. Tujuan utama adalah menciptakan keseimbangan antara kompleksitas pohon dan kemampuan umumnya dalam melakukan klasifikasi yang baik pada data yang tidak terlihat sebelumnya. Teknik pemangkasan ini membantu menghasilkan model pohon keputusan yang lebih umum dan dapat diandalkan.

Terimakasih semoga bermanfaat, dan kamu bisa menemukan apa yang kamu cari. "Jangan Lupa Bernafas dan Tetap Bahagia dalam Tautan Rasa Syukur".

Post a Comment for " Teknik Pruning Algoritma C4.5 - Pemangkasan Pohon Keputusan"

SILAHKAN TANYA DAN DISKUSI DENGAN BIJAK